Diễn đàn quản trị

Thúc đẩy quản trị trí tuệ nhân tạo để kiểm soát rủi ro

Ngoài đạo luật chính thức, rất nhiều quốc gia trên thế giới đã ban hành các bộ nguyên tắc đạo đức liên quan đến AI và thành lập các ủy ban quốc gia nghiên cứu về khung quản lý AI.

AI regulation (quy định về trí tuệ nhân tạo) là từ khóa chỉ việc xây dựng các chính sách và pháp luật của khu vực công để thúc đẩy và quản lý trí tuệ nhân tạo (AI). Năm 2016 với sự kiện ứng dụng AI của AlphaGo đã chiến thắng nhà vô địch thế giới môn cờ vây, các chính phủ và tổ chức đa quốc gia đã bắt đầu quan tâm hơn đến việc phải xây dựng chính sách công cộng để quản trị và kiểm soát công nghệ này.

Bắt đầu từ các quan ngại về đạo đức, những quy định ban đầu của chính phủ tập trung vào những nguyên tắc để đảm bảo tính minh bạch, công bằng, không gây hại, sự riêng tư, có trách nhiệm, đảm bảo sự tự chủ của con người,… của các hệ thống sử dụng AI. Dễ nhận thấy, các nguyên tắc được lập ra để hạn chế những điểm yếu cố hữu của AI như blackbox, bias, vi phạm quyền riêng tư và có tác hại, ảnh hưởng đến sự tự chủ của con người.

Tuy nhiên, nhận thấy các hướng dẫn, các bộ nguyên tắc không có tính bắt buộc về mặt pháp luật và không có những chế tài đủ mạnh để làm ngăn chặn những ứng dụng tiêu cực của công nghệ, các nhà làm luật trên thế giới lại bắt tay soạn thảo những bản luật quy định nghiêm khắc hơn.

2 chính sách ở khối cộng đồng chung châu Âu (EU)

Là một phần trong chiến lược kỹ thuật số của mình, EU muốn quản lý, kiểm soát AI để đảm bảo điều kiện tốt hơn cho việc phát triển và sử dụng công nghệ tiên tiến này.

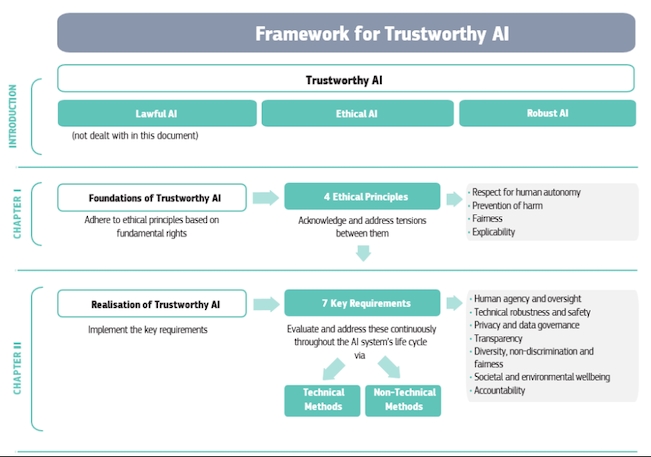

Vào ngày 8/4/2019, nhóm chuyên gia cấp cao của EU đã trình bày Nguyên tắc đạo đức dành cho trí tuệ nhân tạo đáng tin cậy. Theo Bộ nguyên tắc, AI đáng tin cậy phải đảm bảo: tuân thủ tất cả các luật và quy định hiện hành, tôn trọng các nguyên tắc và giá trị đạo đức, và bền vững cả từ góc độ kỹ thuật trong khi tính đến các yếu tố môi trường và xã hội.

Bộ nguyên tắc đưa ra 7 yêu cầu chính mà các hệ thống AI phải đáp ứng để được coi là đáng tin cậy. Một danh sách đánh giá cụ thể nhằm mục đích giúp xác minh việc áp dụng từng yêu cầu chính.

Thứ nhất, các hệ thống AI nên trao quyền cho con người, cho phép họ đưa ra quyết định sáng suốt. Đồng thời, cần đảm bảo các cơ chế giám sát phù hợp trong đó do con người chỉ huy.

Thứ hai, các hệ thống AI cần phải linh hoạt và an toàn.

Thứ ba là đảm bảo tôn trọng đầy đủ quyền riêng tư và bảo toàn chất lượng và tính toàn vẹn của dữ liệu cũng như đảm bảo quyền truy cập hợp pháp vào dữ liệu.

Thứ tư, dữ liệu, hệ thống và mô hình kinh doanh AI phải minh bạch.

Thứ năm, cần tránh sự thiên vị không công bằng vì nó có thể gây ra nhiều tác động tiêu cực, từ việc gạt ra ngoài lề các nhóm dễ bị tổn thương, đến làm trầm trọng thêm định kiến và phân biệt đối xử.

Thứ sáu, các hệ thống AI sẽ mang lại lợi ích cho tất cả mọi người, bao gồm cả các thế hệ tương lai.

Thứ bảy, các cơ chế nên được áp dụng để đảm bảo trách nhiệm và trách nhiệm giải trình đối với các hệ thống AI và kết quả của chúng.

Vào tháng 4/2021, Ủy ban châu Âu đã đề xuất Khung quy định đầu tiên của EU về AI (AI Act), cũng là bộ luật quy định có tính băt buộc đầu tiên trên thế giới.

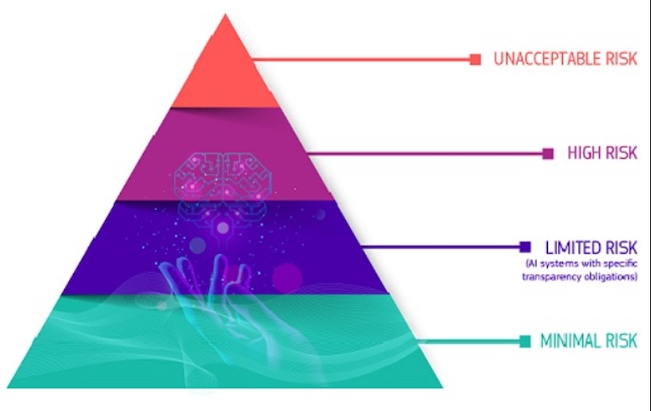

Khung quy định này nói rằng các hệ thống AI sẽ được phân tích và phân loại theo rủi ro mà chúng gây ra cho người dùng. Dự thảo dự định sẽ được thông qua vào cuối năm 2023 và sẽ được áp dụng vào năm 2024.

Thứ nhất là rủi ro không thể chấp nhận được xảy ra khi hệ thống AI được coi là mối đe dọa đối với con người và sẽ bị cấm, chẳng hạn như việc thao túng hành vi nhận thức của con người hoặc các nhóm dễ bị tổn thương cụ thể, ví dụ như đồ chơi kích hoạt bằng giọng nói khuyến khích hành vi nguy hiểm ở trẻ em.

Một ví dụ khác có thể kể đến là phân loại con người dựa trên hành vi, tình trạng kinh tế xã hội hoặc đặc điểm cá nhân hay hệ thống nhận dạng sinh trắc học từ xa và thời gian thực, chẳng hạn như nhận dạng khuôn mặt.

Thứ hai là rủi ro cao xảy ra khi các hệ thống AI ảnh hưởng tiêu cực đến an toàn hoặc các quyền cơ bản. Rủi ro này được chia thành hai loại: các hệ thống AI được sử dụng trong các sản phẩm thuộc luật an toàn sản phẩm của EU; các hệ thống AI thuộc tám lĩnh vực cụ thể sẽ phải đăng ký trong cơ sở dữ liệu của EU.

Một số ví dụ của hệ thống AI có rủi ro cao có thể kể đến như nhận dạng sinh trắc học và phân loại người, quản lý và vận hành cơ sở hạ tầng quan trọng, giáo dục và dạy nghề, việc làm, quản lý người lao động và khả năng tự tạo việc làm, thực thi pháp luật, quản lý di cư, tị nạn và kiểm soát biên giới, hỗ trợ giải thích pháp luật và áp dụng pháp luật…

Tất cả các hệ thống AI có rủi ro cao sẽ được đánh giá trước khi đưa ra thị trường và trong suốt vòng đời của chúng.

Thứ ba là rủi ro hạn chế. Các hệ thống AI có rủi ro hạn chế phải tuân thủ các yêu cầu tối thiểu về tính minh bạch để cho phép người dùng đưa ra quyết định sáng suốt. Điều này bao gồm các hệ thống AI tạo hoặc thao tác với nội dung hình ảnh, âm thanh hoặc video, chẳng hạn như tái tạo lại khuôn mặt của người trong video (deepfakes).

Với tính chất của một quy định bắt buộc, luật này cũng có rất nhiều quy định chế tài nghiêm khắc như phạt tiền từ 10.000USD (hoặc 2% doanh thu toàn cầu) cho hành vi không đăng ký hoặc đăng ký thiếu sót thông tin. Trong các vi phạm nghiêm trọng ví dụ khi cố tình đưa thị trường châu Âu những ứng dụng có rủi ro được xếp vào phân loại không thể chấp nhận được và bị cấm thì mức tiền phạt có thể lên đến 30 triệu USD (hoặc 6% doanh thu toàn cầu).

Quyền riêng tư, bảo mật và chống phân biệt đối xử ở Hoa Kỳ

Là một quốc gia dẫn đầu thế giới về nghiên cứu và phát triển AI, các nhà làm luật và giới học thuật ở Mỹ cũng rất quan tâm đến những mặt tiêu cực của AI.

Tuy là một quốc gia thuộc hệ thống thông luật nên chưa đưa ra các bộ luật dành riêng cho AI và quy định chi tiết như liên minh châu Âu, nước này cũng có một số luật và quy định hiện hành có liên quan đến một số khía cạnh của AI cần lưu ý, chẳng hạn như quyền riêng tư, bảo mật và chống phân biệt đối xử.

Bên cạnh đó chính phủ Hoa Kỳ đã có những hướng dẫn chính thức về các hệ thống AI, trong đó mới nhất là AI Bill of Rights (Tuyên ngôn nhân quyền trong thời đại AI). Dự luật này tuy không bắt buộc nhưng đưa ra một số quyền của người sử dụng với 5 ý chính.

Một là hệ thống an toàn và hiệu quả. Bạn nên được bảo vệ khỏi các hệ thống không an toàn hoặc không hiệu quả.

Hai là bảo vệ chống phân biệt đối xử bằng thuật toán: Bạn không nên đối mặt với sự phân biệt đối xử bằng thuật toán và các hệ thống nên được sử dụng và thiết kế một cách công bằng.

Ba là quyền riêng tư về dữ liệu. Bạn nên được bảo vệ khỏi các hành vi lạm dụng dữ liệu thông qua các biện pháp bảo vệ tích hợp và bạn nên có quyền kiểm soát cách dữ liệu về bạn được sử dụng.

Bốn là thông báo và giải thích. Bạn nên biết rằng một hệ thống tự động đang được sử dụng và hiểu cách thức cũng như lý do hệ thống đó góp phần tạo ra các kết quả ảnh hưởng đến bạn.

Năm là các lựa chọn thay thế, cân nhắc và dự phòng của con người. Bạn sẽ có thể từ chối, khi phù hợp và có quyền tiếp cận với một người có thể nhanh chóng xem xét và khắc phục các vấn đề mà bạn gặp phải.

Ngoài ra, chính quyền địa phương ở Hoa Kỳ cũng nỗ lực đưa ra các luật liên quan đến AI trong đó nổi tiếng nhất có lẽ là Luật kiểm toán thiên vị (Bias Audit Law). Theo đạo luật này, các công ty bị cấm sử dụng các công cụ tự động để tuyển dụng ứng viên hoặc thăng chức cho nhân viên, trừ khi các công cụ đó đã được kiểm toán độc lập về sự thiên vị.

Các biện pháp kiểm soát AI khác trên thế giới

Các quốc gia khác trên thế giới cũng đưa ra luật để kiểm soát AI như Trung Quốc đưa ra dự thảo luật về quản lý các công cụ AI tạo sinh vào tháng 5/2023. Canada cũng giới thiệu dự thảo Luật về trí tuệ nhân tạo và dự liệu vào tháng 2/2023. Vào tháng 6/2023, chính phủ Australia cũng có những động thái cho thấy sẽ ban hành một đạo luật liên quan đến AI qua báo cáo “AI có trách nhiệm và an toàn tại Australia”.

Tương tự, hai quốc gia láng giềng là Singapore và Thái Lan cũng có những hành động đột phá trong việc quản trị AI. Singapore xây dựng AI Verify, khung thử nghiệm quản trị AI và bộ công cụ phần mềm. Thái Lan cũng đang trong quá trình xây dựng bộ luật dành cho hệ thống dịch vụ kinh doanh sử dụng AI.

Ngoài đạo luật chính thức, rất nhiều quốc gia trên thế giới đã ban hành các bộ nguyên tắc đạo đức liên quan đến AI và thành lập các ủy ban quốc gia nghiên cứu về khung quản lý AI. Điều này cho thấy việc yêu cầu kiểm soát công nghệ này đã bắt đầu được quan tâm.

Trong bối cảnh các dịch vụ internet hiện nay là không biên giới, và Việt Nam là trung tâm gia công phần mềm công nghệ thông tin, trong đó có rất nhiều ứng dụng AI, nên cũng cần quan tâm sát sao đến các xu hướng quy định pháp luật liên quan đến AI và dữ liệu trên thế giới.

Những điểm yếu chí mạng của trí tuệ nhân tạo

Đường đến trung tâm trí tuệ nhân tạo của khu vực

Chính phủ Việt Nam đã ban hành Chiến lược quốc gia về AI đến năm 2030, với mục tiêu từng bước đưa Việt Nam trở thành một trung tâm đổi mới sáng tạo và AI nằm trong Top 4 của khu vực ASEAN và trong Top 50 của thế giới.

Cần góc nhìn đa chiều về trí tuệ nhân tạo

Chuyên gia FPT cho rằng công nghệ trí tuệ nhân tạo rất cần được quan tâm vì khả năng tạo ra sự rung chuyển trong tương lai, nhất là với ngành phần mềm.

Nhà thuốc Long Châu đưa trí tuệ nhân tạo vào bán lẻ dược phẩm

Năm ngoái, FPT Long Châu đã cán mốc 1.000 nhà thuốc trong tháng 12/2022, vượt xa kế hoạch mở mới năm 2022. Số lượng nhà thuốc có doanh thu lên đến 937 cửa hàng trên khắp 63 tỉnh thành.

Trí tuệ nhân tạo sẽ là công nghệ cốt lõi của FPT

Hiện hệ sinh thái công nghệ AI của FPT có hơn 20 giải pháp đang phục vụ hơn 20 triệu người dùng cuối và 600 triệu lượt sử dụng/năm.

Doanh nghiệp Việt vươn tầm nhờ đổi mới tư duy quản trị

Khi thế giới bước vào chu kỳ biến động mới, Việt Nam đang đứng trước cơ hội vàng để khẳng định vị thế trong chuỗi giá trị toàn cầu. Với vai trò và kỳ vọng mới, nhiều doanh nghiệp tư nhân đã bắt đầu tạo dấu ấn về năng lực quản trị và tầm nhìn toàn cầu, tạo niềm tin rằng, khi tư duy được đổi mới, doanh nghiệp Việt hoàn toàn có thể đi xa hơn, mạnh hơn và vững vàng ra thế giới.

G-Group: Tài sản số sẽ thay đổi phương thức và văn hóa làm việc

Việc chuyển dịch sang tài sản số theo lãnh đạo G-Group không chỉ là bước tiến về công nghệ, mà còn là sự thay đổi cả về vận hành và văn hóa doanh nghiệp.

Công nghệ và dữ liệu đã đủ, vì sao trải nghiệm khách hàng vẫn đứt gãy?

Công nghệ và dữ liệu giúp doanh nghiệp hiểu khách hàng hơn, nhưng khoảng trống quản trị lại khiến trải nghiệm khách hàng bị đứt gãy ở những thời điểm quan trọng nhất.

5 đòn bẩy chiến lược của doanh nghiệp gia đình

Sự phát triển lâu dài của doanh nghiệp gia đình phụ thuộc vào khả năng kết hợp mục tiêu, nguồn vốn dài hạn và danh tiếng với sự linh hoạt và quản trị chuyên nghiệp.

Affina và cách tiếp cận mới với bảo hiểm trong xã hội già hóa nhanh

Khi Việt Nam bước vào giai đoạn già hóa nhanh, bảo hiểm không thể chỉ là công cụ chi trả rủi ro. Affina mở ra một cách tiếp cận mới cho an sinh bền vững.

Giải cơn khát vốn cho EVN

Tập đoàn Điện lực Việt Nam (EVN) đứng trước áp lực cân đối tài chính cả ngắn và dài hạn trong bối cảnh nhu cầu đầu tư hệ thống điện ngày càng lớn.

Chuyến bay thẳng đầu tiên kết nối TP.HCM và Điện Biên của Vietnam Airlines

Chuyến bay mang số hiệu VN1160 khởi hành từ sân bay Tân Sơn Nhất lúc 9h35 và hạ cánh tại sân bay Điện Biên lúc 11h55, chuyên chở gần 100 hành khách.

Thị trường bất động sản cuối năm: Biệt thự bán đảo dẫn nhịp nguồn cung mới

Thị trường bất động sản quý II ghi nhận mức khan hiếm nguồn cung thấp tầng hiếm thấy trong gần một thập kỷ. Bước sang quý III và IV, dù thị trường có tín hiệu mở lại, lượng cung mới vẫn ở mức chọn lọc, đưa các dự án sở hữu giá trị độc bản - từ địa thế đến chuẩn mực không gian sống trở thành ưu tiên tìm kiếm của nhóm khách hàng thượng lưu.

Từ lễ thắp sáng Giáng sinh đến câu chuyện trải nghiệm của TPBank

Lễ “Thắp sáng Giáng sinh” tại TPBank được tổ chức như một điểm chạm cảm xúc cuối năm. Qua ánh sáng, không gian lễ hội và các tiện ích số quen thuộc, TPBank cho thấy cách ngân hàng số này kết nối với khách hàng bằng sự gần gũi và thấu hiểu.

10 năm dưới tay Central Retail, điện máy Nguyễn Kim kinh doanh ra sao?

Từng là biểu tượng ngành bán lẻ điện máy, Nguyễn Kim đánh mất vị thế trong suốt một thập kỷ về tay doanh nghiệp Thái Lan Central Retail.

NCB tiếp tục kế hoạch tăng vốn lên gần 30.000 tỷ đồng

NCB dự kiến nâng vốn điều lệ lên gần 29.280 tỷ đồng thông qua chào bán riêng lẻ 1 tỷ cổ phiếu cho nhà đầu tư chứng khoán chuyên nghiệp.

Góp ý dự thảo Văn kiện Đại hội XIV: Đột phá từ đội ngũ nhân lực tinh anh

Nhân lực Việt cần một “hệ điều hành” cơ chế đột phá để hình thành đội ngũ tinh anh, đủ sức dẫn dắt các ngành công nghệ chiến lược trong kỷ nguyên mới.